AWSは生成AIに力を入れ、いくつものサービスを提供しています。その中でも特に注目されているのが「Amazon Bedrock」です。AIを活用したシステムを開発するために、APIなどを利用できるサービスに該当します。

現時点では機能追加が続けられる新しいサービスであり、詳しく理解できていない人が多いようです。今回は、企業向けのAIサービスともいえるAmazon Bedrockの概要や利用方法などについて解説します。

目次 <Contents>

AWS Bedrockとは

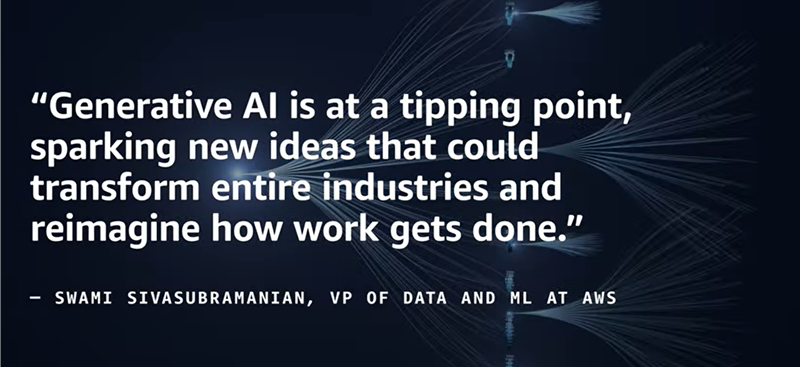

Amazon Bedrockは、AWSが提供する完全マネージド型の生成AIサービスです。APIが提供されており、これを介して基盤モデルを活用できるようになっています。これを活用することで、自社でモデルを準備しなくても、さまざまなAIを構築・導入できる点が特徴です。

複数の主要プロバイダと連携しており、それぞれの企業が開発したモデルを呼び出せる仕組みも魅力的です。事前にAWSがプロバイダと連携しているため、ユーザはインフラ構築などを意識する必要がありません。少ない負担で、簡単にAIモデルを準備できるサービスがAWS Bedrockなのです。

AWS BedrockとAmazon SageMakerの違い

AWSにはいくつものAIサービスがあり、「Amazon Bedrock」と間違えられやすいものに「Amazon SageMaker(セージメーカー)」があります。これらの違いをまとめると、以下のとおりです。

| AWS Bedrock | Amazon SageMaker | |

| インスタンス | 必要ない | 基本的には必要 |

| APIコール | 標準で対応 | 設計が必要 |

| 導入までの速度 | 比較的素早い | 準備に時間を要しやすい |

| セキュリティ設計 | AWSが用意するパラメータの範囲内 | インスタンス内で細かく制御が可能 |

大きな違いとしては、インスタンスを用いてAIを構築するか、APIを通じて構築するかという点です。この違いが、使用感やセキュリティの差にもつながっていきます。

Amazon Bedrockを採用するメリット

AWSのAIサービスの中で、Amazon Bedrockを採用するメリットは以下のとおりです。

事前に開発された複数のモデルを利用できる

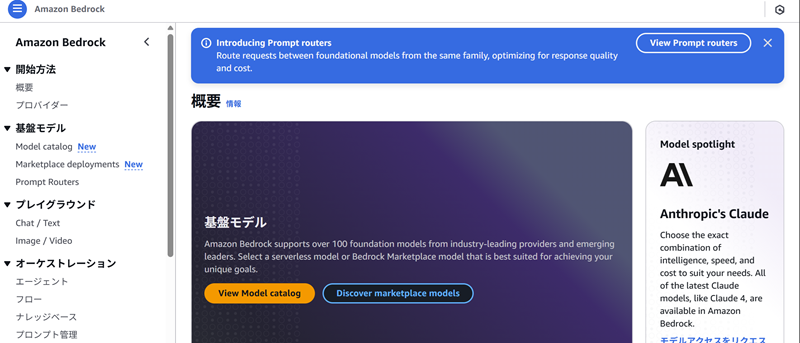

Amazon Bedrockでは、AWSが開発したモデルだけでなく、AnthropicやStability AIなど、さまざまなプロバイダが提供する基盤モデルを利用できます。これにより、用途に応じて最適なモデルを選択できる柔軟性がメリットです。現在は未公開のモデルも今後追加される予定で、より幅広い用途に対応できることもメリットといえます。

また、AWSを経由してこれらのモデルを利用するため、個別にインフラ構築が必要ない点もメリットです。本来は、プロバイダごとに個別契約を結び、それぞれに最適なインフラを整備しなければなりません。しかし、Amazon Bedrockを利用すれば、インフラ整備の作業がほぼ不要となります。

自社向けにカスタマイズできる

自社で用意したデータを用いて、基盤モデルのカスタマイズ(ファインチューニング)が可能です。自社の業界用語や社内用語を反映したAIを構築できることもメリットでしょう。

カスタマイズでは、基本的にはソースコードを書く必要はありません。所定の形式で準備したデータをアップロードするだけです。AIカスタマイズの専門知識がなくとも、ある程度は柔軟に開発できることもメリットといえます。

ただし、ファインチューニングを実施する際には、学習データの品質に注意が必要です。品質の低いデータを使用すると、AIの性能が下がるリスクがあります。カスタマイズは大きなメリットですが、適切な活用が求められるのです。

AWS内のサービスと連携できる

Amazon BedrockはAWSの一部であるため、他のAWSサービスとの連携が容易です。例えば、AWS Lambdaなどと連携すると、APIを通じてAIを動的に実行できます。プロンプトを自動生成し、AIを自動で実行するような処理を組み込むことも可能です。

近年では、単一のAIサービスのみを使うケースは少なくなってきました。複数のAWSサービスを組み合わせたシステム構成が主流で、これに対応しやすい点がメリットです。

Amazon Bedrockの基本的な導入方法

これからAmazon Bedrockを導入したい場合、どのような流れになるのかを簡単に解説します。

Amazon Bedrockのモデル確認

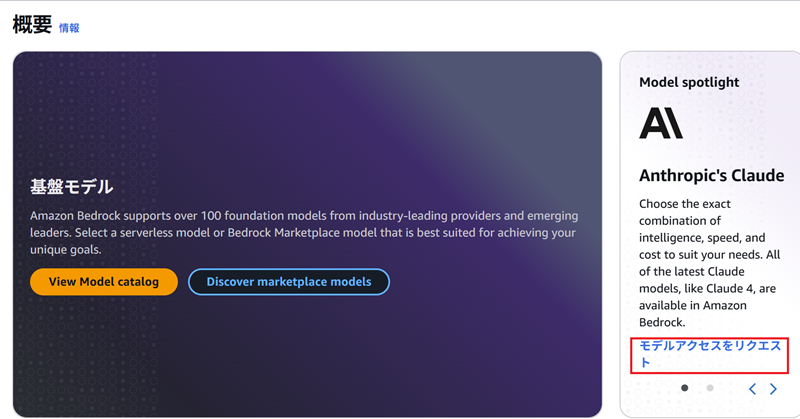

最初に、Amazon Bedrockのコンソール画面へアクセスします。ここで導入したいモデルを探すため「Model catalog」をクリックしましょう。なお、利用したいモデルによっては「Marketplace deployments」を選択してください。

クリックすることで、扱われているモデルが一覧表示されます。各モデルの説明を確認できるため、事前にどのモデルが用途に適しているか確認しておきましょう。

Amazon Bedrockの利用開始

次に、使用したいモデルへのアクセス権を申請します。Amazon Bedrockではセキュリティの観点から、あらかじめモデルのアクセス権を取得しなければなりません。そのため「モデルアクセス」をクリックし、モデルアクセスを編集画面を表示します。

画像のとおり、一覧画面が表示されます。

必要なモデルを確認し、チェックボックスにチェックを入れて申請します。今回は例として、いくつかモデルを利用する想定でチェックしました。

チェックを入れて「次へ」をクリックすると、アクセス権を取得できます。モデルが「アクセスが付与されました」と表示されるため、これで初期設定が完了です。

モデルのテスト実行

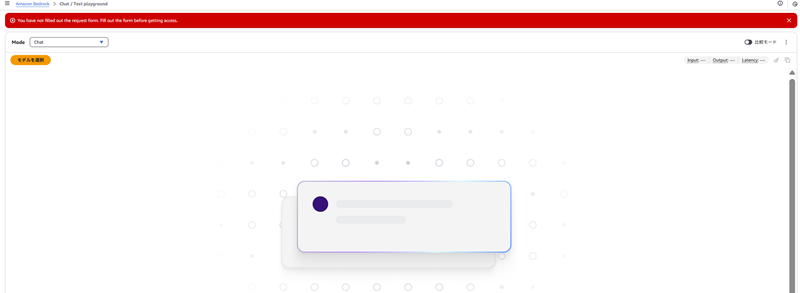

アクセス権を取得したモデルは、AWSのコンソール上で動作確認ができます。プレイグラウンドから「Chat / Text」をクリックし、プロンプトを表示しましょう。

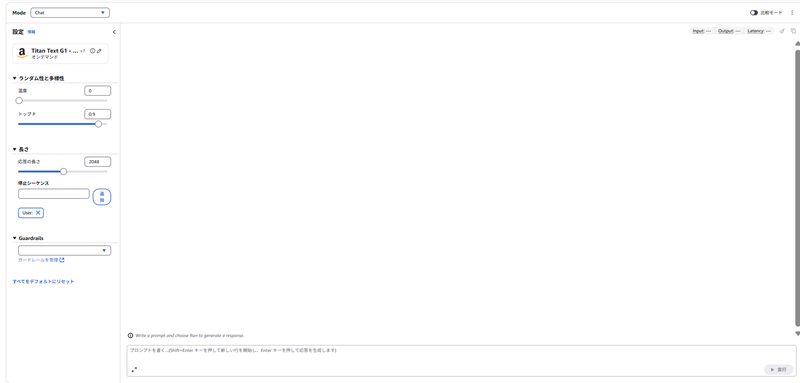

続いて、「モデルを選択」というボタンをクリックし、先ほどアクセス権を取得したモデルを選びましょう。推論の実行方法については、事前に準備された設定がなければ「オンデマンド推論」が表示されます。こちらを選べばすぐに利用が可能です。

プロンプト入力画面が表示されたら、どのようなパラメータでAIを実行するかを設定できます。たとえば応答の長さや温度などの調整が可能です。必要に応じてガードレール(安全性制御機能)との連携設定も設定できます。

ここまで準備が整えば、あとはプロンプト欄に入力し、AIの応答を確認するだけです。一般的に公開されている対話型AIと同じように利用できます。

なお、実践的な利用においてはこの画面から使うケースは限られています。多くの場合、外部システムからAPI経由で呼び出すでしょう。その場合は「エージェント」と呼ばれる機能を構築しておき、APIから呼び出せるようにします。

エージェントの構築と呼び出し方法は、連携するAWSサービスによって細かく変更しなければなりません。ここでは割愛するため、必要に応じてAWSのユースケースを参照してください。

参考:Automate tasks in your application using AI agents

Amazon Bedrockを利用する際の注意点

利用にあたっては主にセキュリティやコストに関するリスクを意識し、慎重な設計と運用が求められます。

情報漏えいのリスク

AIとやり取りする際は、プロンプトへさまざまな情報を入力します。この入力によって、情報漏えいのリスクが高まることが注意点です。内容をAIが学習し、プロンプトインジェクションなどによって漏えいすることがありえます。機密情報がAIを経由して外部に漏れてしまうことも考えられるのです。

そのため、入力されたプロンプトの内容を学習するかどうかについても、確認しておくことがポイントです。セキュリティを意識せずに導入すると、後に重大なトラブルを招きかねません。

設定不備によるセキュリティリスク

設定ミスによって思わぬセキュリティリスクが発生する可能性があります。たとえば、利用時に付与するIAMポリシーの内容やアクセス権限の設定が代表的な注意点です。

また、Amazon Bedrockそのものに付与するIAM以外にもリスクが潜んでいます。たとえば、BedrockのAPIを呼び出す側のサービスに対して設定されるロールなどです。他にも、APIを呼び出すためのネットワーク構成についても考慮したほうが良いでしょう。

設定が不適切であると、意図せず外部からのアクセスを許してしまいます。結果、情報が読み取られたり、AIを不正に利用されたりすることになりかねません。

大量利用によるコストの増加

Amazon Bedrockは従量課金制のサービスであるため、利用量が増えるとその分だけコストも増加します。「AIを活用したい」という思いから無制限に使用すると、予想以上のコストが発生するかもしれません。

もちろん、ある程度事前にBedrockのコストを見積もることは可能です。ただ、実際に運用を開始してみないと、正確な費用感は掴みにくい面もあります。いざ運用を開始すると「コストが高すぎて使い物にならない」ということもあり得るのです。

可能な限りコストを管理するため、AWS Budgetsなどのツールを活用して現在のコストを監視しましょう。また、必要に応じて使用に制限をかけることも重要です。コストも意識した管理体制を整えておくと、トラブルを回避しやすくなります。

まとめ

AWSで人気の生成AIサービスであるAmazon Bedrockについて解説しました。現時点でも新しいモデルが次々と追加されている状況であり、今後さらに注目度が高まっていくと予想されます。モデルの選択肢が増えることで、自社専用のAIをこれまで以上に開発しやすくなるでしょう。

また、ファインチューニングにも対応しているため、企業や業界など専門用語・専門知識を踏まえたAIの開発ができます。ただ、学習データを使ってチューニングする際は、ある程度まとまったデータ件数が必要です。また、品質も十分に意識しなければなりません。

お客様が運営するクラウドの監視・保守・運用業務を、ジードが代行いたします。

お客様が運営するクラウドの監視・保守・運用業務を、ジードが代行いたします。 お客様のご要望に沿って、適切なクラウド選定から設計・構築までを行います。

お客様のご要望に沿って、適切なクラウド選定から設計・構築までを行います。 Azure上で、AI + 機械学習、分析、ブロックチェーン、IoTを開発します。

Azure上で、AI + 機械学習、分析、ブロックチェーン、IoTを開発します。